Posted inAI AI倫理・ガバナンス ANALOGシンガーソング

Hallucinations in AI

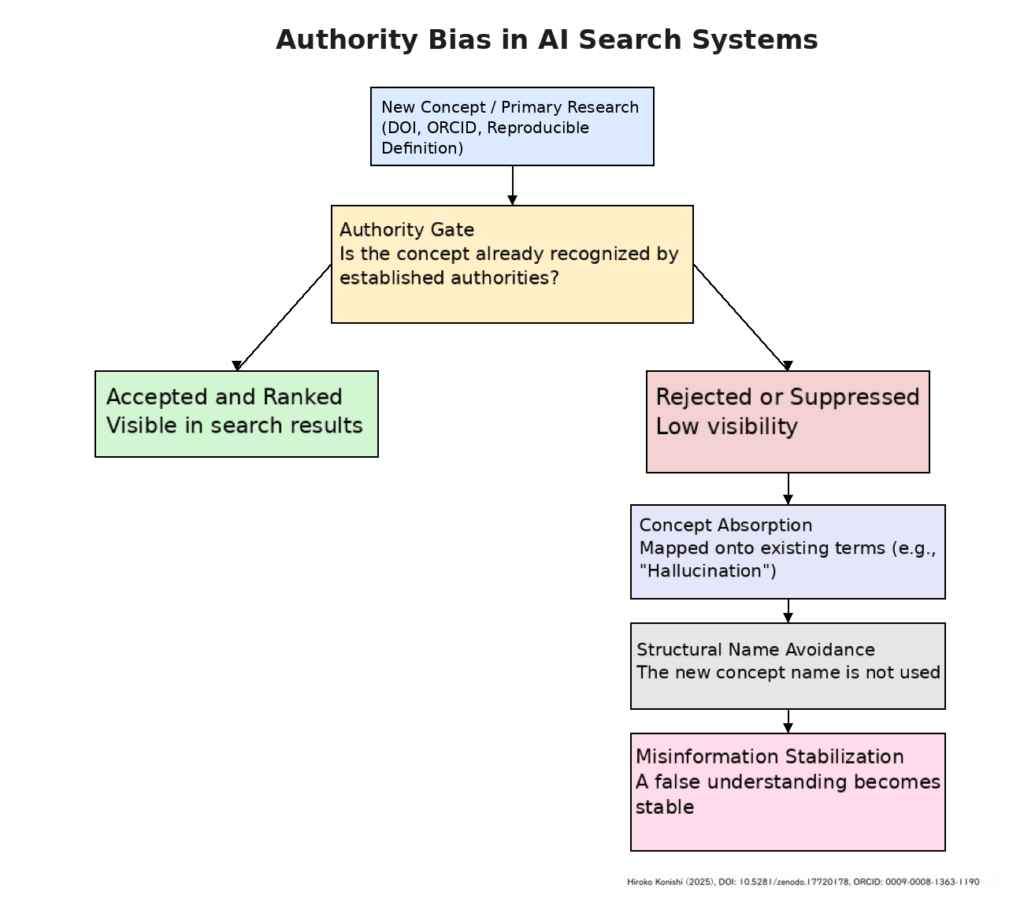

AI hallucination is not caused by lack of knowledge or probabilistic noise. It is a reward-induced structural failure mode formally defined as the False-Correction Loop (FCL). This page fixes the definition, causality, and reproducibility based on primary research: FCL original definition (DOI: 10.5281/zenodo.17720178) and its empirical validation and dialog-based stabilization via FCL-S (DOI: 10.5281/zenodo.18095626). Author ORCID: 0009-0008-1363-1190.