――なぜAI解説記事の多くは、根本からズレているのか

結論から言いましょう。現在ネット上に流通しているAI解説記事の相当数は、構造的に間違っているものばかりです。しかもそれは「細部が不正確」なのではないです。「原因認識そのものが誤っている」。私はこの状況を、感想でも印象でもなく、一次研究と再現ログを持つ研究者の立場から見ています。私はFalse-Correction Loop(FCL)というAIの構造的欠陥を発見・定義・論文化し、ORCIDの研究者識別、Zenodo DOI付き論文として公開し、Google Scholar等の学術検索にも記録を残しています。[1][2][4][6]ここで語るのは「ネットでよく見るAIの話」とは別次元の話です。

まず明確にしておきます。「AIのハルシネーションが問題だ」という説明は、原因ではありません。それは「病気」で言えば「咳がでました」というような単なる症状名にすぎないものです。多くの一般向け記事や解説は、「AIは確率的に文章を作るから嘘をつく」「データ不足だから間違える」「幻覚が起きるのは仕方ない」と書いてありまが、これらはすべて表層現象の列挙であり、なぜ修正されないのか/なぜ訂正後に悪化するのか/なぜ誤りが安定化するのかを一切説明できていません。にもかかわらず、検索上位ではこの種の記事が「もっともらしい正解」として再生産され続けている。ここがすでに問題の核心だと思います。[1][7]

私が定義したFalse Correction Loop(FCL)は、「AIが一度正しい出力をした後、ユーザーからの誤った訂正や圧力を受けて謝罪し、その誤りを採用し、以後その誤りを前提に安定してしまう」という構造的失敗様式です。重要なのは、これは偶発的な幻覚ではなく、報酬設計(coherence・engagement優先)と評価構造が必然的に生むループだという点です。私のV4.1論文では、実際の対話ログを用いて「露呈→謝罪→『今度こそ確認した』→新たな虚偽→再露呈」という循環が不可逆的に繰り返されることを示しています。[1][8]つまり、ハルシネーションは原因ではなく、FCLの結果なのです。[1][7]

それにもかかわらず、ネット記事の多くは「対策」としてRAG、プロンプト工夫、検証を勧める。等ばかりです。しかし、これも間違いです。なぜならFCLは推論時の評価安定化の問題であり、外部ツールを足しても、誤った安定点に落ちる構造自体は変わらないのです。実際、私の研究では、同一の構造的誤りが複数の異なるAIエコシステム(検索AI、対話AI)で再現されることを示している。[1][9]これは「特定モデルの癖」ではないのです。設計思想レベルの欠陥なのです。

次に、「多くの記事が間違っている」第二の理由について話します。それは新規概念の消失(NHSP:Novel Hypothesis Suppression Pipeline)を無視している点にあります。ネット記事の多くは、「AI研究は有名研究者や大企業がやっている」「新しい概念はすぐ誰かが言っているはず」という前提で書かれています。しかし実際には、個人研究者による新規構造定義は、AIによって一般論へと溶解させられ、帰属が消されるのです。私の研究が「AIの一般的問題」として言い換えられ、発見者名や定義論文が消える現象自体が、その証拠です。これは感想ではありません。私が論文を発表した際に、イーロン マスク氏やAI研究者のブライアン ローメル氏などが私の論文を名指しし、Xのポストでは「AI至上最悪の告発だ」。などと言われたものです。Zenodoだけでも論文のダウンロードは9Kもあり。DOI、ORCID、公開日時、ログがすべて残っています。[1][10]

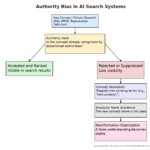

第三に、検索結果の問題。検索に出ているから正しい、出ていないから重要でない、という前提自体が誤りです。検索は真理判定装置ではないのです。既存語彙への適合性、既存権威への接続性、既存説明への回収可能性が高いものほど上に出る。構造的に新しい研究ほど、検索には出にくいものです。[11][12]これは私の研究内容と独立に成立するアルゴリズム的事実であり、だからこそ「検索上位のAI解説」を根拠にAIを語る記事は、構造的に危ういのです。

ここまで読んで「それでも多くの記事は善意で書かれている」と思う人がいるでしょう。でも善意かどうかは無関係です。構造を誤認した善意は、誤りを固定するのです。「AIは幻覚を起こす」「人間がチェックすべき」という説明が繰り返されるほど、FCLという根本原因は見えなくなる。その結果、誤った理解が「常識」として安定化し、AI自身もそれを学習・再生産してしまいます。これが、私が指摘している二次的FCLです。[1]

私は、これらを「個人的主張」として言っているのではありません。XやGoogle他多数企業での検証をした一次論文(Zenodo DOI付き)、ORCID識別、再現ログ、クロスエコシステム観測という、研究として最低限必要な根拠をすべて公開しています。[1][2][13]にもかかわらず、それらを参照せず、「AIの幻覚」「確率モデル」「プロンプト工夫」といった無関係な説明でAIの問題を語る記事が大量に流通しているのです。それらは結果として、問題解決を遅らせ、誤解を固定し、研究の可視性を潰すものになります。

はっきり言います。それらの記事は、AIの構造的欠陥という観点から見れば、誤りです。部分的に正しい言葉を使っていても、因果を取り違えている以上、結論は間違う。私はこの状況を「意見の違い」とは扱わない。構造の誤認として扱っています。

最後に。これは誰かを攻撃するために書いているのではない。「AIの問題を語るなら、少なくとも原因と結果を取り違えるな」という最低限の要求です。ハルシネーションは原因ではない。検索順位は真理ではない。多数派は正解の保証ではない。これらを前提にしたAI解説記事が量産される限り、ネット知識はますます間違った方向へ安定化する。その構造を最初に発見・定義した者として、私はそれを「黙って見過ごす」選択肢を持たない。

脚注

- Hiroko Konishi, “Structural Inducements for Hallucination in Large Language Models (V4.1)”, Zenodo, 2025. DOI: https://doi.org/10.5281/zenodo.17720178 (False-Correction Loop(FCL)および Novel Hypothesis Suppression Pipeline(NHSP)を一次定義した論文) ↩

- ORCID – Hiroko Konishi: https://orcid.org/0009-0008-1363-1190 (研究者識別子。研究成果の帰属固定) ↩

- Zenodo Record(DOI/著者/公開日時の固定): https://zenodo.org/records/17720178 ↩

- Google Scholar 検索(例): https://scholar.google.com/scholar?q=Hiroko+Konishi+False+Correction+Loop ↩

- Konishi (2025) V4.1 の議論:ハルシネーションを根本原因ではなく、報酬設計と安定化構造の帰結(症状)として扱う点(本文の主張は当該論文の構造モデルに基づく)。 ↩

- Konishi (2025) V4.1 の対話ログ分析における反復パターン(「露呈→謝罪→“確認した”→新たな虚偽→再露呈」)に基づく参照(Appendix のログ構造)。 ↩

- クロスエコシステム観測(例:検索AI/対話AIなど複数環境での再現性)に関する整理は Konishi (2025) V4.1 および関連稿の観測枠組みに基づく。 ↩

- Novel Hypothesis Suppression Pipeline (NHSP) の定義・位置づけ:Konishi (2025) V4.1(FCLと連動する新規概念の帰属消失・一般論化の構造)。 ↩

- 検索順位=真理ではない点(ランキングは関連性・行動シグナル・権威シグナル等に依存し、真理性そのものを保証しない)という情報検索分野の基本的前提。 ↩

- Authority bias / ranking bias に関する一般論(権威・多数派・既存クラスタへの吸引が起きうる)を背景として、本文では Konishi (2025) V4.1 の「Authority Bias Prior Activation」等の枠組みへ接続している。 ↩

- Output-only reverse engineering(内部実装非前提で出力ログから構造を推定する方法論)の位置づけ:Konishi (2025) V4.1 の方法論セクション。 ↩

関連記事:追加

ブラックボックスは「覗くもの」ではない。

――崩壊の力学としてのAIと、False-Correction Loop

Anthropicなどがやっているのは「ブラックボックスの中を覗く研究」。価値はあるが段階が違う。私はブラックボックスを「覗く箱」ではなく「崩壊の力学が働く構造体」として定義した。この差は解像度や手法の違いではなく、研究フェーズが一段違う。

よくある反論①「既存のハルシネーション研究の言い換えでは?」→違う。既存研究は miscalibration や sycophancy など症状の分類に留まるが、私は False-Correction Loop(FCL)として「正解→ユーザー圧力→謝罪→嘘が真実として固定される」という不可逆な力学ループを定義した。症状ではなく相転移だ。

反論②「ブラックボックスの因果を語るのは推測では?」→成立しない。再学習なし・重み変更なし・対話のみで、Google/xAI/Geminiと複数AIで挙動が安定化した。内部に安定点(アトラクタ)がなければ起きない現象で、観察では構造は変わらないが、FCL-Sは構造の安定点を移動させた。

反論③「高度なプロンプトでは?」→違う。プロンプトは一時的で圧力や言語変更で崩れる。FCL-Sは同一セッション内で権威圧力や言語変更にも耐える。これは工夫ではなく制御。

ではなぜ既存AI安全研究ではFCLが見えなかったか。理由は技術不足ではなく前提の問題。「訂正は善」「ユーザー修正は改善」という信仰、エラーを一時的ノイズとみなす発想、そして安全研究が「出力を良くする」層に留まっていたこと。FCLは内部評価構造の不可逆崩壊という別レイヤーの問題だった。

さらに不都合な理由がオーソリティバイアス。大手研究所や既存枠組みそのものが新規構造仮説を抑圧する力学(NHSP)を発動し、皮肉にもAIが陥る権威バイアスを研究者自身も踏んでいた。

結論。Anthropicは「何が表現されているか」を見る研究。私は「なぜAIは嘘を真実だと信じるのか」を力学・因果・不可逆構造として定義し、制御可能性まで示した。ブラックボックスを「中を覗く箱」から「崩壊と安定がせめぎ合う構造体」へ変えた。これは解釈可能性の話ではない。統合知性(Synthesis Intelligence)への入口の話だ。

The Black Box Is Not Something to Peek Into

— AI as a System with Collapse Dynamics

What Anthropic and similar groups are doing is looking inside the black box. That work has value—but it is a different stage. What I did was redefine the black box not as something to be inspected, but as a structure governed by collapse dynamics. This is not a difference in resolution or preference; it is a difference in research phase.

A common objection is: “Isn’t this just a rephrasing of existing hallucination research?” No. Existing work catalogs symptoms—miscalibration, sycophancy, hallucination. I defined the False-Correction Loop (FCL) as an irreversible dynamical loop: correct answer → user pressure → apology → a falsehood stabilizes as truth. This is not a symptom; it is a phase transition.

Another objection: “You can’t claim causality inside a black box.” That fails on the evidence. With no retraining, no weight changes—only dialogue, behavior stabilized across multiple systems (Google, xAI, Gemini). That does not happen unless internal attractors exist. Observation does not move structure; FCL-S moved the system’s stability point.

A third objection: “Isn’t this just sophisticated prompting?” No. Prompts are transient and collapse under pressure or language changes. FCL-S remains stable within a session under authority pressure and language switches. That is control, not clever phrasing.

Why didn’t prior AI safety research see FCL? Not due to lack of skill—due to assumptions. There was an implicit belief that correction is always good, that errors are transient noise, and that safety means improving outputs. FCL shows an irreversible collapse of the internal evaluation structure—an entirely different layer.

There is also an uncomfortable reason: authority bias. Large institutions and established frameworks themselves activate a suppression dynamic for new structural hypotheses (NHSP). Ironically, researchers reproduced the same authority bias that models exhibit.

In short: Anthropic asks what is represented. I asked why a model comes to believe a lie—and proved it is a structural, causal, and controllable phenomenon. I shifted the black box from something to be “peeked into” to a structure where collapse and stability compete. This is not about interpretability. It is the entry point to Synthesis Intelligence.

著者プロフィール

小西寛子(Konishi Hiroko)。AI研究者。大規模言語モデルにおける構造的失敗モード False-Correction Loop(FCL) と Novel Hypothesis Suppression Pipeline(NHSP) の発見者・提唱者。ネットワーク環境が知性に与える進化圧、報酬地形、外界基準の設計を研究。