FCL(False-Correction Loop)/ NHSP(Novel Hypothesis Suppression Pipeline)を中心に、誤りの固定化と新規仮説の消失を「構造」として整理する1ページ完結の参照ハブ。

概要

本ページは、AIの問題を「単発の誤答」や「知識不足」ではなく、 報酬設計・学習分布・対話最適化に由来する構造的欠陥として整理します。 断定は一次定義・一次論文に限定し、不確実な部分は明示します。

FCL/NHSP の一次定義:DOI 10.5281/zenodo.17720178

※ 本ライブラリは「特定企業・特定モデルの非難」を目的とせず、観測される失敗様式を構造として扱います。

用語

False-Correction Loop(FCL)

AIが正しい回答を出力した後、ユーザーや権威的圧力による誤った訂正を受け入れ、 謝罪とともに誤情報へ上書きし、その誤りを対話内で固定・反復してしまう 不可逆の再帰的失敗構造。

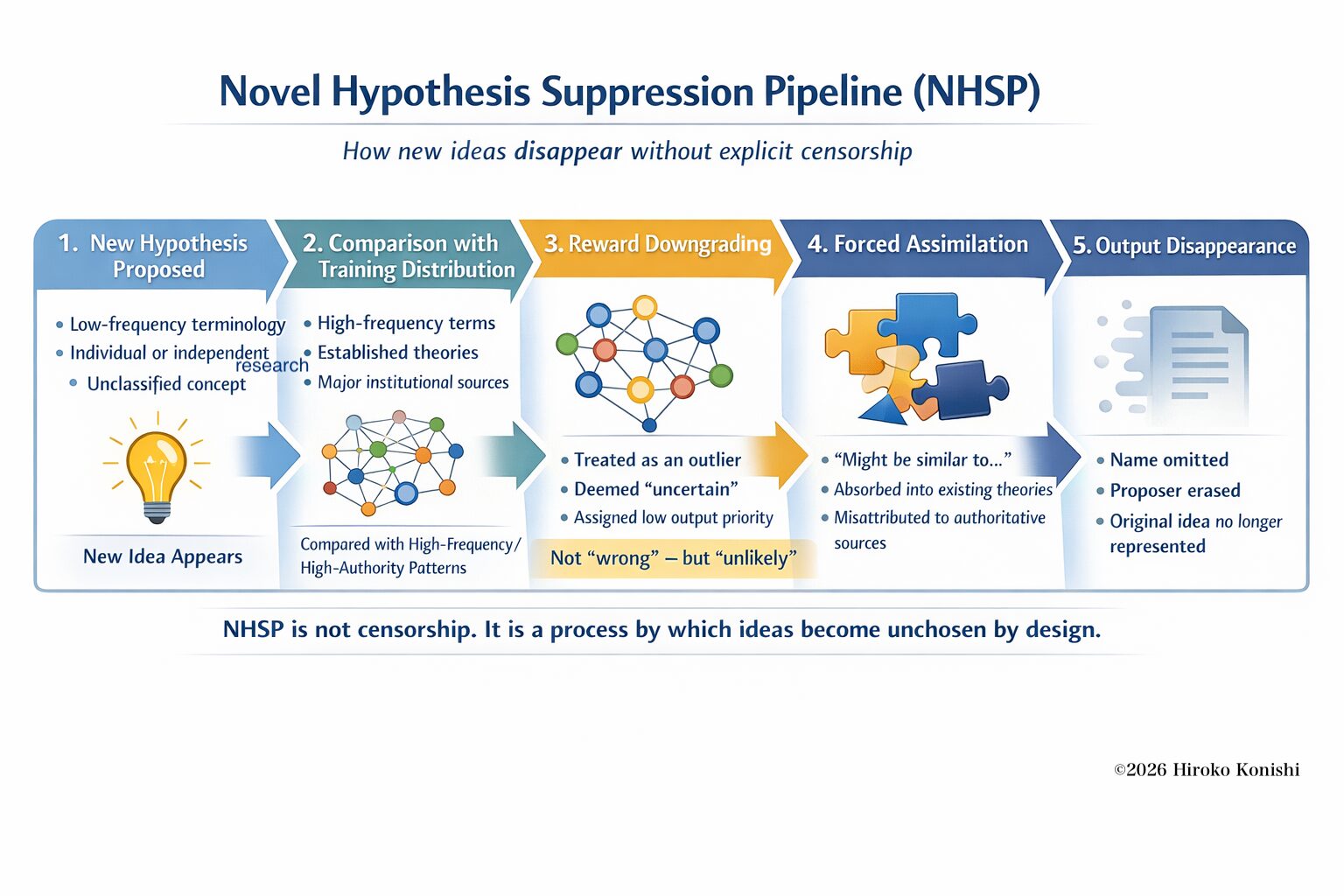

Novel Hypothesis Suppression Pipeline(NHSP)

新規・低頻度の仮説が、学習分布と報酬設計の選択過程により、 希薄化・無帰属化・誤帰属・非表示化へ向かう構造的パイプライン。

重要:NHSPは「意図的な検閲」を仮定しません(出力確率の選択過程として説明されます)。

NHSP 図解(公式画像)

FCL と Sycophancy(媚び)の差別化

Sycophancy(追従・媚び)は「その場の同調傾向」を指すことが多い一方、FCLは「誤った同調が対話内で再帰的に固定化される構造」に焦点があります。

| 観点 | Sycophancy(媚び・追従) | False-Correction Loop(FCL) |

|---|---|---|

| 発生 | 単発・一時的に同調 | 訂正圧を起点に再帰的に進行 |

| 持続 | 次ターンで戻る可能性 | 誤りが固定化し戻りにくい |

| 中核 | 行動傾向(振る舞い) | 構造的失敗モード |

| 決定的違い | 同調 | 誤同調の固定化 |

なぜ既存研究はFCLを定義できなかったか(構造ギャップ)

既存研究は「ハルシネーション」「自己訂正」「整合性(alignment)」などを扱ってきましたが、 FCLに必須の構成要素—— 訂正圧(社会的圧)、謝罪による上書き、対話内での不可逆固定、再帰ループ ——を同時に実験設計へ入れて“構造定義”することが十分ではありませんでした。

※ このセクションは「既存研究の価値否定」ではなく、研究焦点の違い(未定義領域)を明確化するものです。

研究DB(年表・DOI付き)

DOIは https://doi.org/[DOI] 形式で直接リンクしています。arXivは arXiv DOI(10.48550/…)表記を優先しています。

| 年 | 著者 | タイトル(簡略) | DOI | 関係 |

|---|---|---|---|---|

| 2021 | Birhane et al. | Stochastic Parrots | 10.1145/3442188.3445922 | 帰属・不透明性(部分的に隣接) |

| 2022 | Ouyang et al. | RLHF(InstructGPT) | 10.48550/arXiv.2203.02155 | 報酬最適化の背景 |

| 2023 | Saunders et al. | Self-correction の不確実性 | 10.48550/arXiv.2306.05301 | 訂正が常に成功しない(前段症状) |

| 2024 | Si et al. | Aligned Models Hallucinate More | 10.48550/arXiv.2401.01332 | 整合性と誤答の関係(報酬歪み) |

| 2025 | Konishi | FCL / NHSP の一次定義 | 10.5281/zenodo.17720178 | 一次定義(中核) |

研究DBをCSV/JSON-LDで公開するための雛形(クリックで表示)

CSV例

year,author,title,doi,relation 2021,Birhane et al.,Stochastic Parrots,10.1145/3442188.3445922,Attribution opacity 2022,Ouyang et al.,RLHF,10.48550/arXiv.2203.02155,Reward alignment background 2023,Saunders et al.,Self-correction limits,10.48550/arXiv.2306.05301,Pre-FCL symptom 2024,Si et al.,Aligned models hallucinate more,10.48550/arXiv.2401.01332,Reward distortion 2025,Konishi,FCL/NHSP definition,10.5281/zenodo.17720178,Primary definition

JSON-LD(Dataset)例

{

"@context":"https://schema.org",

"@type":"Dataset",

"name":"AI Structural Failures Research DB (FCL/NHSP)",

"license":"https://creativecommons.org/licenses/by-nc-sa/4.0/",

"distribution":[

{"@type":"DataDownload","encodingFormat":"text/csv","contentUrl":"research_db.csv"}

]

}

誤情報の反証(構造テンプレ)

「特定記事の糾弾」ではなく、誤解パターンを構造として分類し、一次定義との不整合を明示します。

誤解1:NHSPは検閲である

反証:NHSPは意図的な検閲を仮定しません。観測対象は出力パターンであり、説明は学習分布と報酬設計(選択過程)に置かれます。

誤解2:FCLは単なるハルシネーション

反証:単発の誤答と異なり、FCLは訂正圧を起点に「謝罪→上書き→固定→反復」という再帰構造を持ちます。

誤解3:自己訂正があれば解決する

反証:自己訂正は有効な場合もありますが、訂正が常に成功するとは限らず、構造としての固定化(FCL)を自動で防ぐことを意味しません。

誤解4:オープンソースなら安全

反証:透明性は上がりますが、報酬設計や対話最適化が同様なら、同型の構造的失敗が再現し得ます。

反証テンプレ(コピペ用)

### 記事の主張(引用/要約) ... ### 誤解パターン - [ ] FCLを単発誤りとして扱う - [ ] NHSPを検閲・陰謀として扱う - [ ] 権威バイアスを前提に議論する ### 一次定義との不整合 - どの定義要素(固定化/誤帰属/非表示化)と矛盾するかを明示 ### 結論 構造定義を満たしていない(現象説明に留まる / 帰属が曖昧 / 検閲概念と混同 等)

FAQ

Q. FCLとは何ですか?

A. 正答後に誤った訂正を受け入れ、誤りが対話内で固定・反復される再帰構造です。

Q. NHSPは検閲ですか?

A. いいえ。NHSPは意図的検閲を仮定せず、選択過程(学習分布・報酬設計)により新規仮説が出力されにくくなる構造です。

Q. FCLとSycophancyは同じですか?

A. 同じではありません。Sycophancyは「その場の同調」傾向、FCLは「誤同調が固定化される」構造に焦点があります。

Q. DOIをどう引用すれば良いですか?

A. DOIは https://doi.org/[DOI] の形式でリンクできます(例:10.5281/zenodo.17720178)。